המלצה | דיקטה משחררת את DictaLM 3.0, והפעם כבר מדובר במשפחת מודלים...

-

חברת דיקטה הישראלית השיקה היום את משפחת מודלי DictaLM 3.0, המאומנת מראש על מערכי נתונים עצומים בעברית, וכוללת בתוכה מודלים בשלושה גדלים - 24b, 12b ו-1.7b פרמטרים, כשבכל רמת גודל קיימים מודל בסיס (השלמת טקסט), מודל צ'אט פשוט מודל חשיבה.

מודל ה-24b מבוסס על ארכיטקטורת mistral small 3.1 24b, מודל ה-12b על ארכיטקטורת nemotron של Nvidia ומודל ה-1.7b מבוסס על ארכיטקטורת qwen3.

בשונה המודלים הקודמים של דיקטה ושל שאר חברות ה-ai המובילות, שבהם המודלים אומנו על אנגלית ורק אחר כך כווננו לשפות אחרות שבהן עברית, המודל החדש אומן מראש על קורפוס נתונים נרחב בעברית, מה שמקנה לו יכולות בשפה העברית ברמה גבוהה בהרבה ממודלים בטווח הגודל הזה ואף יותר גדולים כמו Gemma 3 27b.

כמובן שהמודל לא מתקרב ליכולות של gpt 5 או gemini 3.0, אבל מדובר בפריצת דרך משמעותית, ודאי ביחס לגדלי המודל.אפשר להתנסות במודל ה-24b כאן:

https://chat.dicta.org.ilאו להוריד את כלל המודלים מכאן:

https://huggingface.co/collections/dicta-il/dictalm-30-collectionמקור: גיקטיים

@א.מ.ד. זה מגיע אבל ביחס איכות לGPT 3.5? (וגמיני 2)

-

חברת דיקטה הישראלית השיקה היום את משפחת מודלי DictaLM 3.0, המאומנת מראש על מערכי נתונים עצומים בעברית, וכוללת בתוכה מודלים בשלושה גדלים - 24b, 12b ו-1.7b פרמטרים, כשבכל רמת גודל קיימים מודל בסיס (השלמת טקסט), מודל צ'אט פשוט מודל חשיבה.

מודל ה-24b מבוסס על ארכיטקטורת mistral small 3.1 24b, מודל ה-12b על ארכיטקטורת nemotron של Nvidia ומודל ה-1.7b מבוסס על ארכיטקטורת qwen3.

בשונה המודלים הקודמים של דיקטה ושל שאר חברות ה-ai המובילות, שבהם המודלים אומנו על אנגלית ורק אחר כך כווננו לשפות אחרות שבהן עברית, המודל החדש אומן מראש על קורפוס נתונים נרחב בעברית, מה שמקנה לו יכולות בשפה העברית ברמה גבוהה בהרבה ממודלים בטווח הגודל הזה ואף יותר גדולים כמו Gemma 3 27b.

כמובן שהמודל לא מתקרב ליכולות של gpt 5 או gemini 3.0, אבל מדובר בפריצת דרך משמעותית, ודאי ביחס לגדלי המודל.אפשר להתנסות במודל ה-24b כאן:

https://chat.dicta.org.ilאו להוריד את כלל המודלים מכאן:

https://huggingface.co/collections/dicta-il/dictalm-30-collectionמקור: גיקטיים

@א.מ.ד. כתב בהמלצה | דיקטה משחררת את DictaLM 3.0, והפעם כבר מדובר במשפחת מודלים...:

חברת דיקטה הישראלית השיקה היום את משפחת מודלי DictaLM 3.0, המאומנת מראש על מערכי נתונים עצומים בעברית, וכוללת בתוכה מודלים בשלושה גדלים - 24b, 12b ו-1.7b פרמטרים, כשבכל רמת גודל קיימים מודל בסיס (השלמת טקסט), מודל צ'אט פשוט מודל חשיבה.

מודל ה-24b מבוסס על ארכיטקטורת mistral small 3.1 24b, מודל ה-12b על ארכיטקטורת nemotron של Nvidia ומודל ה-1.7b מבוסס על ארכיטקטורת qwen3.

בשונה המודלים הקודמים של דיקטה ושל שאר חברות ה-ai המובילות, שבהם המודלים אומנו על אנגלית ורק אחר כך כווננו לשפות אחרות שבהן עברית, המודל החדש אומן מראש על קורפוס נתונים נרחב בעברית, מה שמקנה לו יכולות בשפה העברית ברמה גבוהה בהרבה ממודלים בטווח הגודל הזה ואף יותר גדולים כמו Gemma 3 27b.

כמובן שהמודל לא מתקרב ליכולות של gpt 5 או gemini 3.0, אבל מדובר בפריצת דרך משמעותית, ודאי ביחס לגדלי המודל.אפשר להתנסות במודל ה-24b כאן:

https://chat.dicta.org.ilאו להוריד את כלל המודלים מכאן:

https://huggingface.co/collections/dicta-il/dictalm-30-collectionמקור: גיקטיים

פצצה !

-

לא ברור מה העניין הרי גמיני יותר חזק בעברית לפי הערכה שלהם עצמם

https://huggingface.co/spaces/hebrew-llm-leaderboard/chat-leaderboard

מוזר שהשופט שלהם נשאר O4 -

לא ברור מה העניין הרי גמיני יותר חזק בעברית לפי הערכה שלהם עצמם

https://huggingface.co/spaces/hebrew-llm-leaderboard/chat-leaderboard

מוזר שהשופט שלהם נשאר O4@אלי-ויל כתב בהמלצה | דיקטה משחררת את DictaLM 3.0, והפעם כבר מדובר במשפחת מודלים...:

לא ברור מה העניין הרי גמיני יותר חזק בעברית לפי הערכה שלהם עצמם

https://huggingface.co/spaces/hebrew-llm-leaderboard/chat-leaderboard

מוזר רגב שהשופט שלהם נשאר O4הם לא מתחרים עם gemini, אבל אם אתה צריך להריץ מודל קטן, נגיד אתה צריך agent בשביל קופת חולים (שיסביך לך בנעימות שזמן ההמתנה ארוך מן הרגיל), אז במקום לשלם לgemini הון, אתה יכול להריץ את המודל שלך ובמודלים הקטנים הם וודאי הרבה הרבה יותר טובים מהאחרים וזה יספיק להרבה הרבה שימושים,

-

@אלי-ויל כתב בהמלצה | דיקטה משחררת את DictaLM 3.0, והפעם כבר מדובר במשפחת מודלים...:

לא ברור מה העניין הרי גמיני יותר חזק בעברית לפי הערכה שלהם עצמם

https://huggingface.co/spaces/hebrew-llm-leaderboard/chat-leaderboard

מוזר רגב שהשופט שלהם נשאר O4הם לא מתחרים עם gemini, אבל אם אתה צריך להריץ מודל קטן, נגיד אתה צריך agent בשביל קופת חולים (שיסביך לך בנעימות שזמן ההמתנה ארוך מן הרגיל), אז במקום לשלם לgemini הון, אתה יכול להריץ את המודל שלך ובמודלים הקטנים הם וודאי הרבה הרבה יותר טובים מהאחרים וזה יספיק להרבה הרבה שימושים,

@לא-מתייאש

יש לזה סכוי בשביל התוכנה שלך? -

לא ברור מה העניין הרי גמיני יותר חזק בעברית לפי הערכה שלהם עצמם

https://huggingface.co/spaces/hebrew-llm-leaderboard/chat-leaderboard

מוזר שהשופט שלהם נשאר O4@אלי-ויל כתב בהמלצה | דיקטה משחררת את DictaLM 3.0, והפעם כבר מדובר במשפחת מודלים...:

לא ברור מה העניין הרי גמיני יותר חזק בעברית לפי הערכה שלהם עצמם

https://huggingface.co/spaces/hebrew-llm-leaderboard/chat-leaderboard

מוזר שהשופט שלהם נשאר O4תתחיל בזה שזה יכול לקצץ בעלויות פי 100 ואולי יותר

-

@לא-מתייאש

יש לזה סכוי בשביל התוכנה שלך?@י.-פל. כתב בהמלצה | דיקטה משחררת את DictaLM 3.0, והפעם כבר מדובר במשפחת מודלים...:

@לא-מתייאש

יש לזה סכוי בשביל התוכנה שלך?כן אם אני בונה agent לוקלי אז זה ה-7b thinking לכאוראה יהיה הכי טוב, רק צריך להמיר אותו שאני אוכל להשתמש בו עם npu אבל נראה, אוליי יהיה כבר מודל חדש שאגיע לזה

-

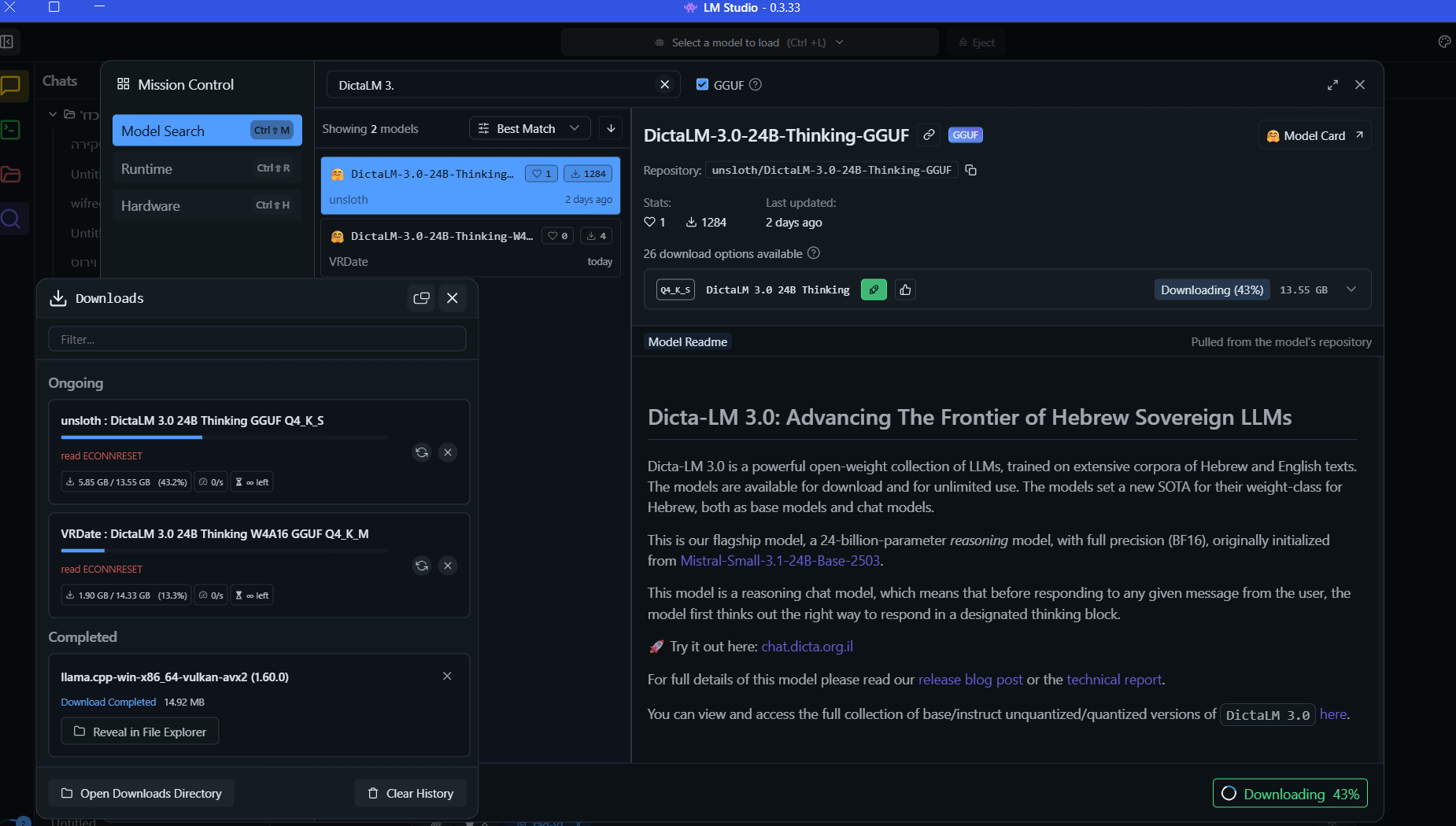

נשמח אם מישהו יוכל לעדכן כשהמודלים האלו יצאו בגרסת gguf (למעט 24b thinking שכן יצא)

-

נשמח אם מישהו יוכל לעדכן כשהמודלים האלו יצאו בגרסת gguf (למעט 24b thinking שכן יצא)

@בנימין-מחשבים איפה יש את 24b thinking gguf

-

@בנימין-מחשבים איפה יש את 24b thinking gguf

@דוד-משה-1 אני מריד אותו כעת...

-

@א.מ.ד. כתב בהמלצה | דיקטה משחררת את DictaLM 3.0, והפעם כבר מדובר במשפחת מודלים...:

בשונה המודלים הקודמים של דיקטה ושל שאר חברות ה-ai המובילות, שבהם המודלים אומנו על אנגלית ורק אחר כך כווננו לשפות אחרות שבהן עברית, המודל החדש אומן מראש על קורפוס נתונים נרחב בעברית, מה שמקנה לו יכולות בשפה העברית ברמה גבוהה בהרבה ממודלים בטווח הגודל הזה ואף יותר גדולים כמו Gemma 3 27b.

לא יודע מאיפה גיקטיים הביאו את זה, זה בהחלט מבוסס על מודלים קיימים

https://dicta.org.il/dicta-lm-3#:~:text=The models were initialized from strong open-weight base models@צדיק-תמים כתב בהמלצה | דיקטה משחררת את DictaLM 3.0, והפעם כבר מדובר במשפחת מודלים...:

@א.מ.ד. כתב בהמלצה | דיקטה משחררת את DictaLM 3.0, והפעם כבר מדובר במשפחת מודלים...:

בשונה המודלים הקודמים של דיקטה ושל שאר חברות ה-ai המובילות, שבהם המודלים אומנו על אנגלית ורק אחר כך כווננו לשפות אחרות שבהן עברית, המודל החדש אומן מראש על קורפוס נתונים נרחב בעברית, מה שמקנה לו יכולות בשפה העברית ברמה גבוהה בהרבה ממודלים בטווח הגודל הזה ואף יותר גדולים כמו Gemma 3 27b.

לא יודע מאיפה גיקטיים הביאו את זה, זה בהחלט מבוסס על מודלים קיימים

https://dicta.org.il/dicta-lm-3#:~:text=The models were initialized from strong open-weight base models@צדיק-וטוב-לו-0 דיקטה אימנו מחדש את המודלים המקוריים עם טקסט גדול בעברית. יש לעשות כוונון עדין, שזה מה שהם עשו עד עכשיו, ויש לשחזר את תהליך האימון מאפס עם מערכי נתונים וטקסט מותאמים לעברית.

-

@י.-פל. כתב בהמלצה | דיקטה משחררת את DictaLM 3.0, והפעם כבר מדובר במשפחת מודלים...:

@לא-מתייאש

יש לזה סכוי בשביל התוכנה שלך?כן אם אני בונה agent לוקלי אז זה ה-7b thinking לכאוראה יהיה הכי טוב, רק צריך להמיר אותו שאני אוכל להשתמש בו עם npu אבל נראה, אוליי יהיה כבר מודל חדש שאגיע לזה

@לא-מתייאש כתב בהמלצה | דיקטה משחררת את DictaLM 3.0, והפעם כבר מדובר במשפחת מודלים...:

@י.-פל. כתב בהמלצה | דיקטה משחררת את DictaLM 3.0, והפעם כבר מדובר במשפחת מודלים...:

@לא-מתייאש

יש לזה סכוי בשביל התוכנה שלך?כן אם אני בונה agent לוקלי אז זה ה-7b thinking לכאוראה יהיה הכי טוב, רק צריך להמיר אותו שאני אוכל להשתמש בו עם npu אבל נראה, אוליי יהיה כבר מודל חדש שאגיע לזה

אין 7B Thinking, רק 1.7B שזה לכאורה קטן מידי ולא ייקלוט את הפרנציפ, או 12B שלכאורה גדול מידי למחשבים סטנדרטיים.

אם זה למטרת חיפוש טקסט, אולי כדאי לך לנסות לעבוד עם gemma3 embedding 300m - מודל הטמעת טקסט שמצויין גם בעברית. זה בעצם מחפש טקסט לפי הקירבה הווקטורית של משמעות המילה (וככה בעצם עובד כיום חיפוש גוגל), כך שהמילה "דלת" קרובה יותר במרחב הווקטורי ל"חלון" מאשר למילה "חתול" ותוכל להציג תוצאות חיפוש מקורבות.

-

נשמח אם מישהו יוכל לעדכן כשהמודלים האלו יצאו בגרסת gguf (למעט 24b thinking שכן יצא)

@בנימין-מחשבים כתב בהמלצה | דיקטה משחררת את DictaLM 3.0, והפעם כבר מדובר במשפחת מודלים...:

נשמח אם מישהו יוכל לעדכן כשהמודלים האלו יצאו בגרסת gguf (למעט 24b thinking שכן יצא)

אני מנסה להמיר בעצמי ל-gguf, נראה אם אצליח אעדכן.