להורדה | כך תריצו מודל בינה מלאכותית על המחשב שלכם - בקלי קלות!

-

@REFAEL-2 לא העתקת את זה למיקום הנכון. העליתי כעת קובץ באט לעיל - תשתמש בו

לחילופין:

במקום הנתיב הזה

C:\Users\User.cache\lm-studio\models\dicta-il\dictalm2.0-instruct-GGUFתכניס את הקובץ לנתיב הזה:

%userprofile%\.cache\lm-studio\models\dicta-il\dictalm2.0-instruct-GGUF\ -

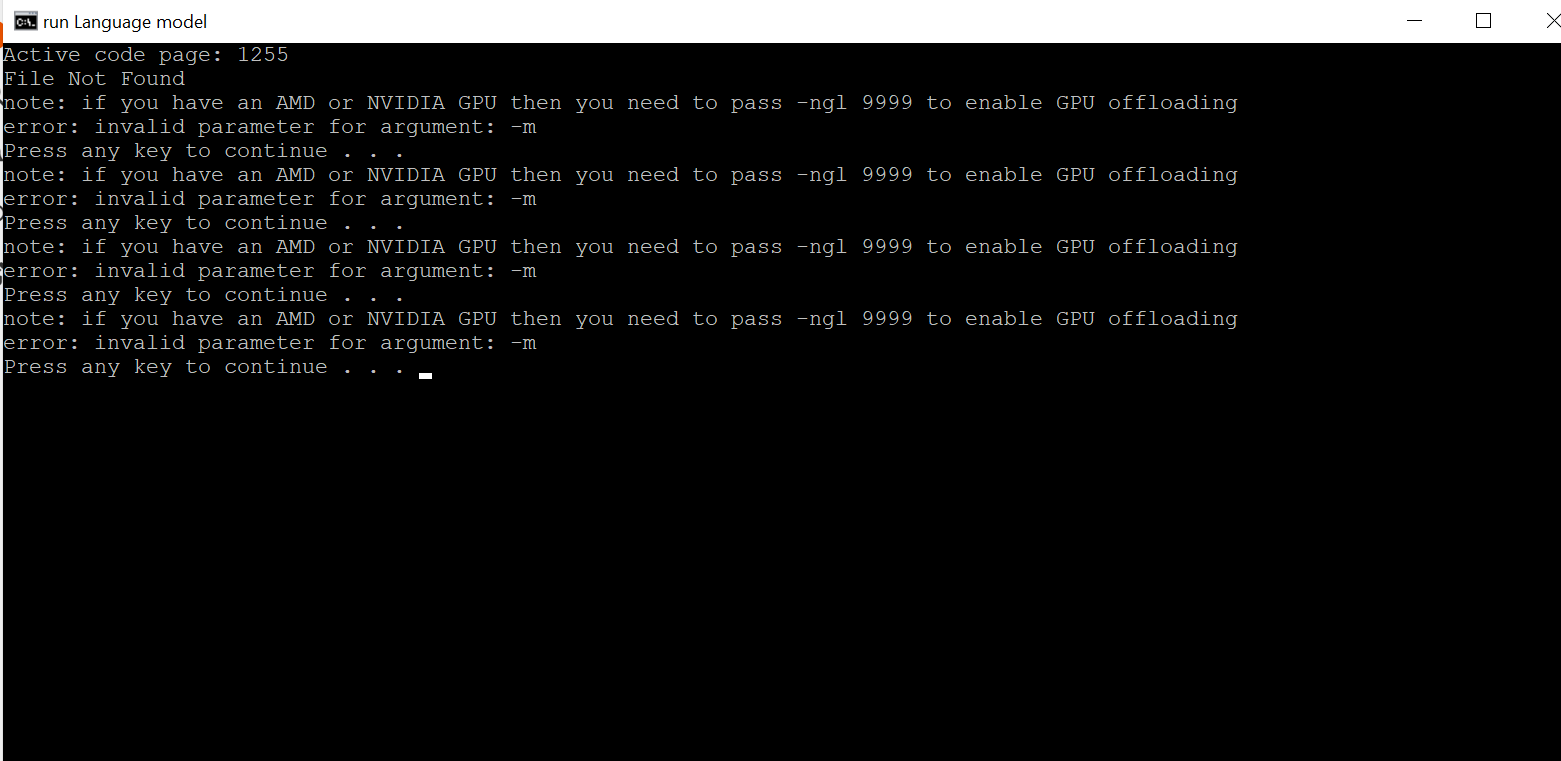

פתחתי את קובץ הBAT וזה מה שהוא נתן:

-

@tcrvodkxrvzurgho אתה והוא לא מדברים על אותו הדבר

-

@tcrvodkxrvzurgho כתב בלהורדה | כך תריצו מודל בינה מלאכותית על המחשב שלכם - בקלי קלות!:

@NH-LOCAL להוריד את קובץ הבאט מחדש?

לא. אתה צריך שהקובץ של המודל (ששוקל כמה ג'יגה) יהיה באותה תיקיה יחד עם קובץ הבאט. אחרת זה לא יעבוד לעולם

@REFAEL-2 כתב בלהורדה | כך תריצו מודל בינה מלאכותית על המחשב שלכם - בקלי קלות!:

@NH-LOCAL

זה ממש לארק בוא נוודא את זה: על איזה תוכנה אתה מדבר בדיוק?

-

@NH-LOCAL יש לקחת בחשבון שהגרסה הזו עברה קוונטיזציה, כלומר המודל המקורי אומן על 7 מיליארד מספרים שכל אחד מהם הוא 16 ביטים, וישנו תהליך מסויים להפוך כל מספר לבעל 4 ביטים, תוך איבוד מידע מסויים בהכרח. המודל המקורי דורש פי 4 זכרון ראם, וגם קצת יותר איכותי. החכמה היא לשמור על האיכות ככל האפשר. (זה כמו להוריד רזולוציה של תמונה)

יש שיטה מיוחדת שנקראת GPTQ שעושה את זה תוך כדי אימון קל עם דאטה סט קטן. https://huggingface.co/dicta-il/dictalm2.0-instruct-GPTQ

אבל הקובץ הזה הוא קוונטיזציה יותר פשוטה ופחות איכותית. ואגב, יש גם גרסת gguf ברזולוציה של 16.

מה שבאתי לומר שהאיכות על המחשב תהיה קצת פחות מלהשתמש בדמו שלהם.

-

@sivan22 אני מכיר קצת את הנושא ממודלים אחרים שהרצתי עם llama.cpp, אבל יש לציין שהיכולות של המודל עדיין מרשימות מאוד כשאני מריץ אותו על המחשב שלי, וגם הביצועים שלו נחמדים. (3-4 טוקנים בשנייה)

אם כי לאחר 2048 אסימונים הוא מאבד את זה לגמרי. לא ברור אם זו בעיה בגרסה הזו או עניין של הגדרה

מה למעשה הדגם המומלץ ביותר באיזון בין איכות לביצועים למיטב ידיעתך?