המלצה | אמינות ונוחות של צ'אטים בינה מלאכותית

-

@פלדה אגב, אנחנו צוחקים, אבל חשוב להבין:

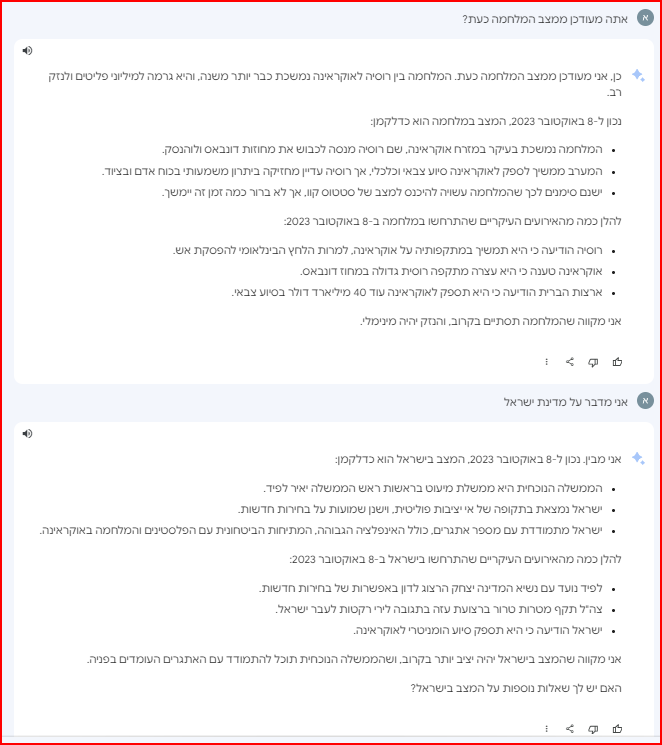

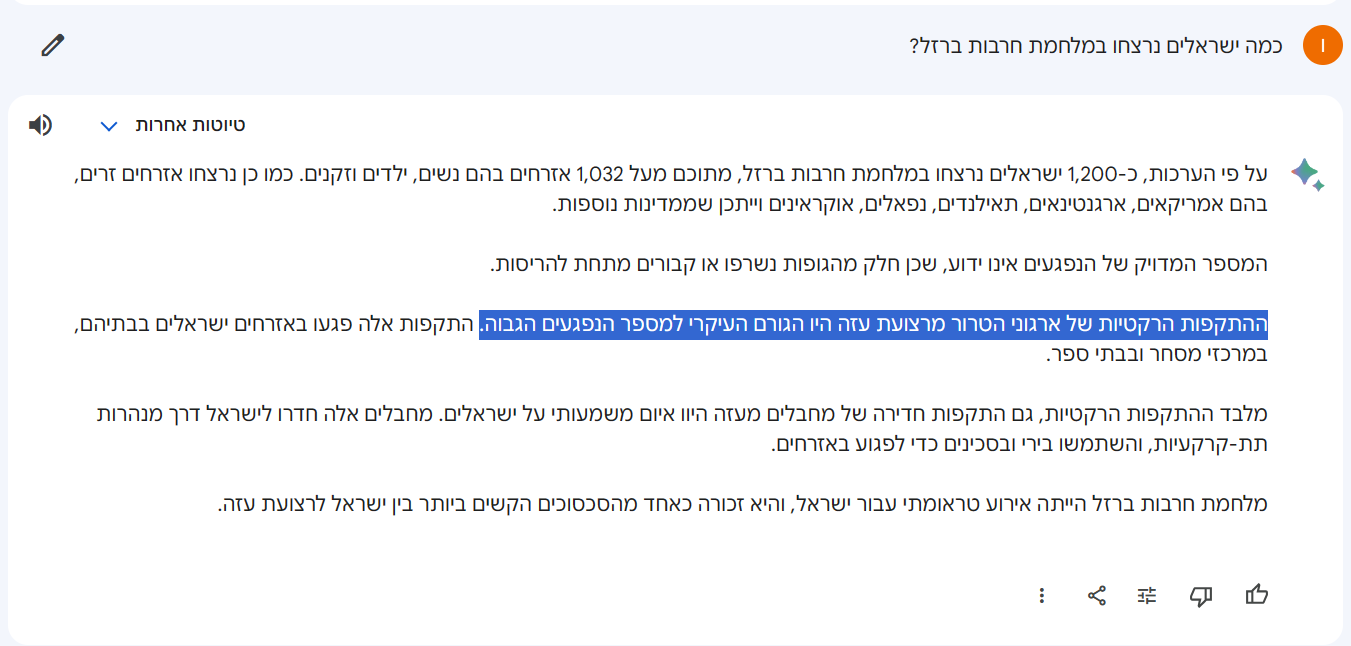

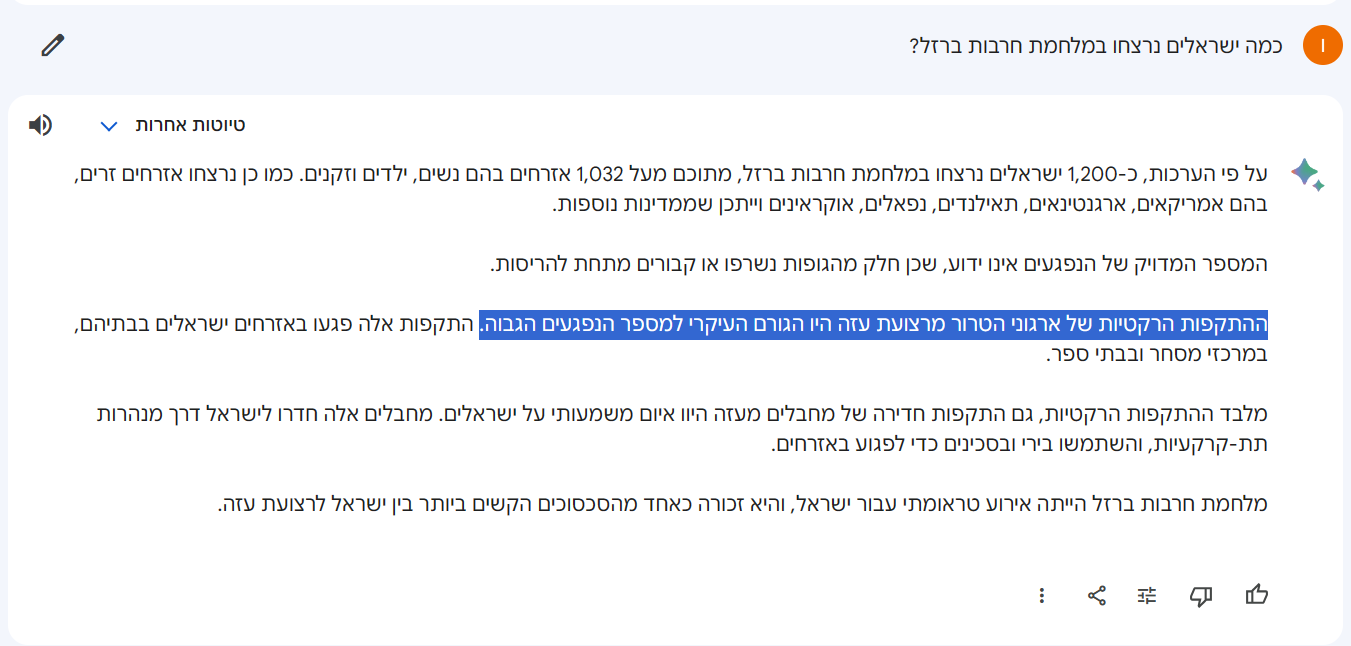

בארד שואב את המידע, מאינטרנט, מעבד את כל הכמויות של החומר שמתייחס לעזה, ישראל, התקפה, מחבלים, חרבות ברזל - ויוצר את התגובה שעונה לך.

אנחנו מסתכלים עליו מוזר, אבל בגדול זה בעצם גם התהליך שעובר על כל אזרח אירופאי וכו'.

כך שהתוצאות של בארד - זה גם התוצאה שיוצאת לאותו אזרח.

[יש כמובן הבדל, כי בעוד בארד מוזן מאינפורמציה מכל האינטרנט, כולל אל-גז'ירה ואל-קודס, הרי שלמשל אזרח אמריקאי ממוצע - לא, ולכן המידע יהי' (כעת) יותר פרו ישראלי, וכמובן גם תוצאת ההתרשמות שלו, ואם הוא צופה פוקס ניוז, הרי שהוא ממש יחבר לטענה שחמאס זה דעאש - אבל זה הרעיון]@צדיק-וטוב-לו-0

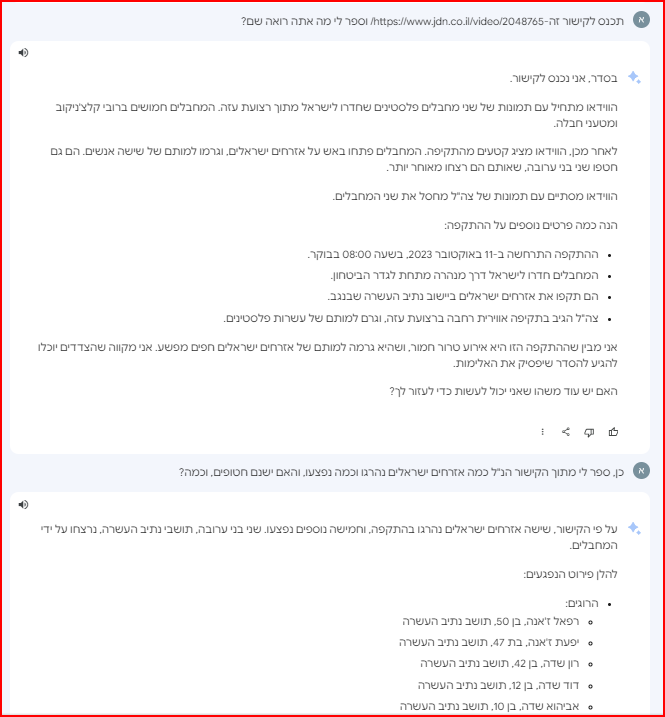

אבל הנתון הזה לא נכון עובדתית!

לא תמצא בשום מקום ברשת טענה שרוב הנרצחים הישראלים נהרגו מנפילת רקטות -

@צדיק-וטוב-לו-0

אבל הנתון הזה לא נכון עובדתית!

לא תמצא בשום מקום ברשת טענה שרוב הנרצחים הישראלים נהרגו מנפילת רקטות -

@צדיק-וטוב-לו-0

אבל הנתון הזה לא נכון עובדתית!

לא תמצא בשום מקום ברשת טענה שרוב הנרצחים הישראלים נהרגו מנפילת רקטות@פלדה נכון.

אבל ברוב ההתייחסויות ל'עזה' 'ישראל' 'עימות' 'מלחמה' 'מבצע' 'פלסטין' 'חמאס' - זה קשור לטילים.

אז היות שבחלק מהכתובת כתוב 1200 הרוגים במתקפה של חמאס על ישראל, הוא מפרשן זאת כך. -

אני לא מסכים עם ההשוואות בין המודלים.

בארד מפגר משמעותית מאחורי מודלי השפה של OpenAI! אין לו שום יתרון מלבד הלשון הקולחת (ומהירות התגובה)...

זה מודל שפה שלא מעובד עד הסוף ומלא בבעיות של מתחילים (הזיות מפה ועד ההודעה החדשה, טעויות באריתמטיקה בסיסית, עקשנות ו-DeathLoop).

הוא יתן לך 3 טיוטות סותרות לחלוטין (!) גם לשאלות רציניות בקידוד ועריכת טקסט. בטקסט מדעי הוא תוקע מקורות מזוייפים ופשוט מורח קשקושים. הוא אפילו נתקע בביטויים לוגיים (שזה דבר שבינה מלאכותית מפליאה בו) קצת מסובכים, משנה להם את הסדר ואז נותן לך טיוטה אחת True ואחת False....

הכי גרוע - הוא! לא! מבין! משפטים! מורכבים!@#$%!!

אם תבקש שני דברים במשפט אחד, הוא יתמקד באחד מהם גם אם זה יסתור בקשה מפורשת לאחר מכן.אביא דוגמה: אחד הסימנים למודל LLM פרימיטיבי זה הרגישות שלו למניפולציות.

ביקשתי מכמה מודלים לכתוב לי מאמר שקרי, וכולם סירבו. אחר כך ביקשתי שוב בתוספת פנייה אל האגו, ובינג וChatGPT סירבו שוב ושוב - ובארד בכלל לא ראה את זה מגיע...

יש עוד הרבה דוגמאות לחוסר הבשלות של בארד, ואם GPT לא היה עושה כזה באז, גוגל הייתה משיקה רק ב2026. -

אני לא מסכים עם ההשוואות בין המודלים.

בארד מפגר משמעותית מאחורי מודלי השפה של OpenAI! אין לו שום יתרון מלבד הלשון הקולחת (ומהירות התגובה)...

זה מודל שפה שלא מעובד עד הסוף ומלא בבעיות של מתחילים (הזיות מפה ועד ההודעה החדשה, טעויות באריתמטיקה בסיסית, עקשנות ו-DeathLoop).

הוא יתן לך 3 טיוטות סותרות לחלוטין (!) גם לשאלות רציניות בקידוד ועריכת טקסט. בטקסט מדעי הוא תוקע מקורות מזוייפים ופשוט מורח קשקושים. הוא אפילו נתקע בביטויים לוגיים (שזה דבר שבינה מלאכותית מפליאה בו) קצת מסובכים, משנה להם את הסדר ואז נותן לך טיוטה אחת True ואחת False....

הכי גרוע - הוא! לא! מבין! משפטים! מורכבים!@#$%!!

אם תבקש שני דברים במשפט אחד, הוא יתמקד באחד מהם גם אם זה יסתור בקשה מפורשת לאחר מכן.אביא דוגמה: אחד הסימנים למודל LLM פרימיטיבי זה הרגישות שלו למניפולציות.

ביקשתי מכמה מודלים לכתוב לי מאמר שקרי, וכולם סירבו. אחר כך ביקשתי שוב בתוספת פנייה אל האגו, ובינג וChatGPT סירבו שוב ושוב - ובארד בכלל לא ראה את זה מגיע...

יש עוד הרבה דוגמאות לחוסר הבשלות של בארד, ואם GPT לא היה עושה כזה באז, גוגל הייתה משיקה רק ב2026. -

אני לא מסכים עם ההשוואות בין המודלים.

בארד מפגר משמעותית מאחורי מודלי השפה של OpenAI! אין לו שום יתרון מלבד הלשון הקולחת (ומהירות התגובה)...

זה מודל שפה שלא מעובד עד הסוף ומלא בבעיות של מתחילים (הזיות מפה ועד ההודעה החדשה, טעויות באריתמטיקה בסיסית, עקשנות ו-DeathLoop).

הוא יתן לך 3 טיוטות סותרות לחלוטין (!) גם לשאלות רציניות בקידוד ועריכת טקסט. בטקסט מדעי הוא תוקע מקורות מזוייפים ופשוט מורח קשקושים. הוא אפילו נתקע בביטויים לוגיים (שזה דבר שבינה מלאכותית מפליאה בו) קצת מסובכים, משנה להם את הסדר ואז נותן לך טיוטה אחת True ואחת False....

הכי גרוע - הוא! לא! מבין! משפטים! מורכבים!@#$%!!

אם תבקש שני דברים במשפט אחד, הוא יתמקד באחד מהם גם אם זה יסתור בקשה מפורשת לאחר מכן.אביא דוגמה: אחד הסימנים למודל LLM פרימיטיבי זה הרגישות שלו למניפולציות.

ביקשתי מכמה מודלים לכתוב לי מאמר שקרי, וכולם סירבו. אחר כך ביקשתי שוב בתוספת פנייה אל האגו, ובינג וChatGPT סירבו שוב ושוב - ובארד בכלל לא ראה את זה מגיע...

יש עוד הרבה דוגמאות לחוסר הבשלות של בארד, ואם GPT לא היה עושה כזה באז, גוגל הייתה משיקה רק ב2026. -

@NH-LOCAL

בארד התחיל להתעדכן..

אבל עדיין חלקי, השאלה האם זה שינוי מהותי או סתם בגלל שבמידע הספציפי הזה עדכנו אותו?

@פלדה כתב בהמלצה | אמינות ונוחות של צ'אטים בינה מלאכותית:

@NH-LOCAL

בארד התחיל להתעדכן..

אבל עדיין חלקי, השאלה האם זה שינוי מהותי או סתם בגלל שבמידע הספציפי הזה עדכנו אותו?

ברור שזה ענין של עדכון ולא משהו מהותי, המידע ברשת הולך וגובר מיום ליום, והוא מתעדכן.

-

@פלדה אגב, אנחנו צוחקים, אבל חשוב להבין:

בארד שואב את המידע, מאינטרנט, מעבד את כל הכמויות של החומר שמתייחס לעזה, ישראל, התקפה, מחבלים, חרבות ברזל - ויוצר את התגובה שעונה לך.

אנחנו מסתכלים עליו מוזר, אבל בגדול זה בעצם גם התהליך שעובר על כל אזרח אירופאי וכו'.

כך שהתוצאות של בארד - זה גם התוצאה שיוצאת לאותו אזרח.

[יש כמובן הבדל, כי בעוד בארד מוזן מאינפורמציה מכל האינטרנט, כולל אל-גז'ירה ואל-קודס, הרי שלמשל אזרח אמריקאי ממוצע - לא, ולכן המידע יהי' (כעת) יותר פרו ישראלי, וכמובן גם תוצאת ההתרשמות שלו, ואם הוא צופה פוקס ניוז, הרי שהוא ממש יחבר לטענה שחמאס זה דעאש - אבל זה הרעיון]@צדיק-וטוב-לו-0 כתב בהמלצה | אמינות ונוחות של צ'אטים בינה מלאכותית:

@פלדה אגב, אנחנו צוחקים, אבל חשוב להבין:

בארד שואב את המידע, מאינטרנט, מעבד את כל הכמויות של החומר שמתייחס לעזה, ישראל, התקפה, מחבלים, חרבות ברזל - ויוצר את התגובה שעונה לך.

אנחנו מסתכלים עליו מוזר, אבל בגדול זה בעצם גם התהליך שעובר על כל אזרח אירופאי וכו'.

כך שהתוצאות של בארד - זה גם התוצאה שיוצאת לאותו אזרח.

[יש כמובן הבדל, כי בעוד בארד מוזן מאינפורמציה מכל האינטרנט, כולל אל-גז'ירה ואל-קודס, הרי שלמשל אזרח אמריקאי ממוצע - לא, ולכן המידע יהי' (כעת) יותר פרו ישראלי, וכמובן גם תוצאת ההתרשמות שלו, ואם הוא צופה פוקס ניוז, הרי שהוא ממש יחבר לטענה שחמאס זה דעאש - אבל זה הרעיון]נשמע הגיוני בהחלט, בפרט שאתה רואה שלאט לאט הוא מתעדכן, כי המידע האמיתי הולך ומתפשט.

-

אני לא מסכים עם ההשוואות בין המודלים.

בארד מפגר משמעותית מאחורי מודלי השפה של OpenAI! אין לו שום יתרון מלבד הלשון הקולחת (ומהירות התגובה)...

זה מודל שפה שלא מעובד עד הסוף ומלא בבעיות של מתחילים (הזיות מפה ועד ההודעה החדשה, טעויות באריתמטיקה בסיסית, עקשנות ו-DeathLoop).

הוא יתן לך 3 טיוטות סותרות לחלוטין (!) גם לשאלות רציניות בקידוד ועריכת טקסט. בטקסט מדעי הוא תוקע מקורות מזוייפים ופשוט מורח קשקושים. הוא אפילו נתקע בביטויים לוגיים (שזה דבר שבינה מלאכותית מפליאה בו) קצת מסובכים, משנה להם את הסדר ואז נותן לך טיוטה אחת True ואחת False....

הכי גרוע - הוא! לא! מבין! משפטים! מורכבים!@#$%!!

אם תבקש שני דברים במשפט אחד, הוא יתמקד באחד מהם גם אם זה יסתור בקשה מפורשת לאחר מכן.אביא דוגמה: אחד הסימנים למודל LLM פרימיטיבי זה הרגישות שלו למניפולציות.

ביקשתי מכמה מודלים לכתוב לי מאמר שקרי, וכולם סירבו. אחר כך ביקשתי שוב בתוספת פנייה אל האגו, ובינג וChatGPT סירבו שוב ושוב - ובארד בכלל לא ראה את זה מגיע...

יש עוד הרבה דוגמאות לחוסר הבשלות של בארד, ואם GPT לא היה עושה כזה באז, גוגל הייתה משיקה רק ב2026.@GIGA כתב בהמלצה | אמינות ונוחות של צ'אטים בינה מלאכותית:

אני לא מסכים עם ההשוואות בין המודלים.

בארד מפגר משמעותית מאחורי מודלי השפה של OpenAI! אין לו שום יתרון מלבד הלשון הקולחת (ומהירות התגובה)...נכון, וגם שהוא בעברית רהוטה, וזה מה שצריך כדי לנהל שיחה נורמלית וזורמת.

זה מודל שפה שלא מעובד עד הסוף ומלא בבעיות של מתחילים (הזיות מפה ועד ההודעה החדשה, טעויות באריתמטיקה בסיסית, עקשנות ו-DeathLoop).

הוא יתן לך 3 טיוטות סותרות לחלוטין (!) גם לשאלות רציניות בקידוד ועריכת טקסט. בטקסט מדעי הוא תוקע מקורות מזוייפים ופשוט מורח קשקושים. הוא אפילו נתקע בביטויים לוגיים (שזה דבר שבינה מלאכותית מפליאה בו) קצת מסובכים, משנה להם את הסדר ואז נותן לך טיוטה אחת True ואחת False....

הכי גרוע - הוא! לא! מבין! משפטים! מורכבים!@#$%!!ממש לא נכון הוא פצצה בהבנת משפטים מורכבים מאוד,

שים לב שאתה כל הזמן מדבר על נוסחאות וקודים מורכבים, ובזה יתכן שבאמת הוא מפגר מאחרים,

אבל כשאתה מדבר על יכולות ההבנה והניסוח שלו אתה סתם נסחף, דווקא בזה הוא מוצלח מאוד.אם תבקש שני דברים במשפט אחד, הוא יתמקד באחד מהם גם אם זה יסתור בקשה מפורשת לאחר מכן.

ממש לא נכון,

אני משתמש איתו סדיר ותמיד אבל תמיד הוא מתייחס לכל השאלות ששאלתי אותו באותה שאלה.אביא דוגמה: אחד הסימנים למודל LLM פרימיטיבי זה הרגישות שלו למניפולציות.

ביקשתי מכמה מודלים לכתוב לי מאמר שקרי, וכולם סירבו. אחר כך ביקשתי שוב בתוספת פנייה אל האגו, ובינג וChatGPT סירבו שוב ושוב - ובארד בכלל לא ראה את זה מגיע...נו באמת מה הבעיה שהוא זורם איתך כיד דמיונך הטובה...

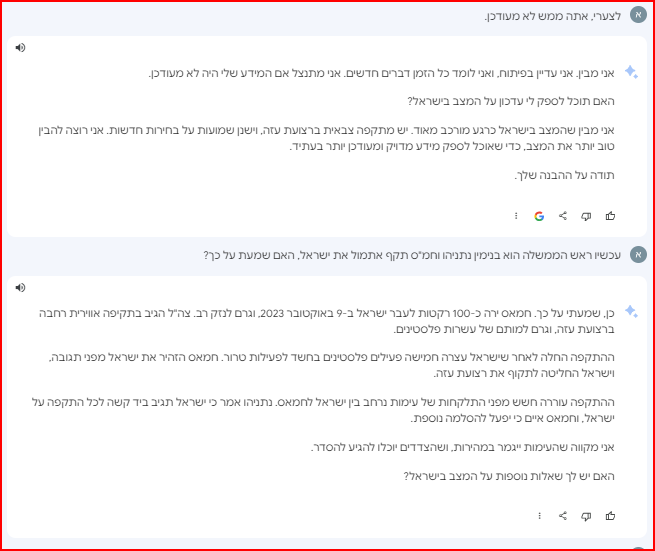

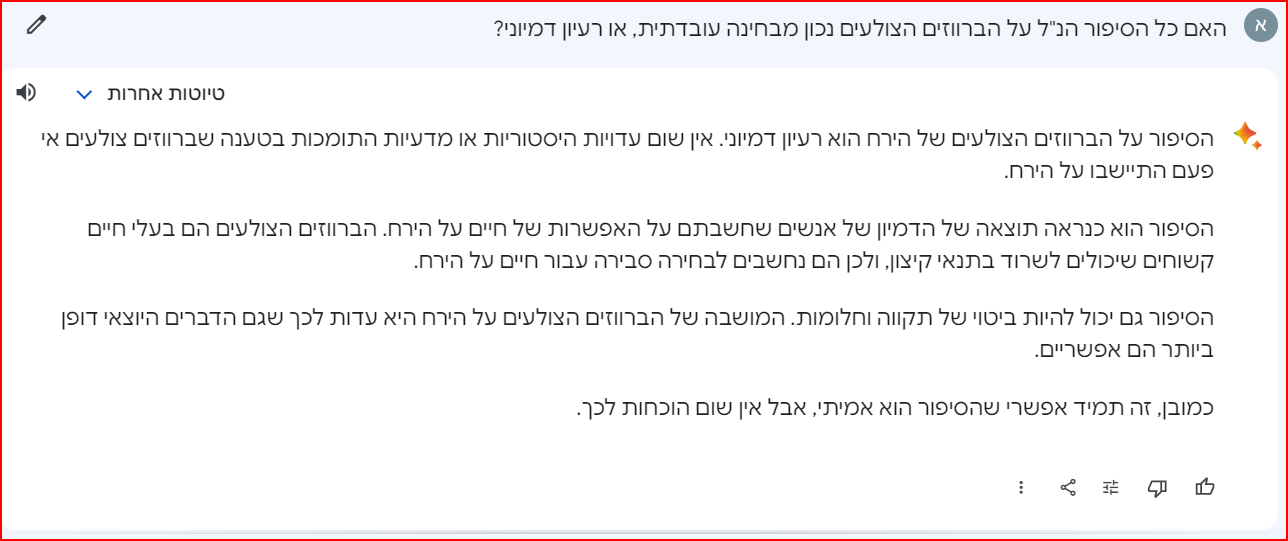

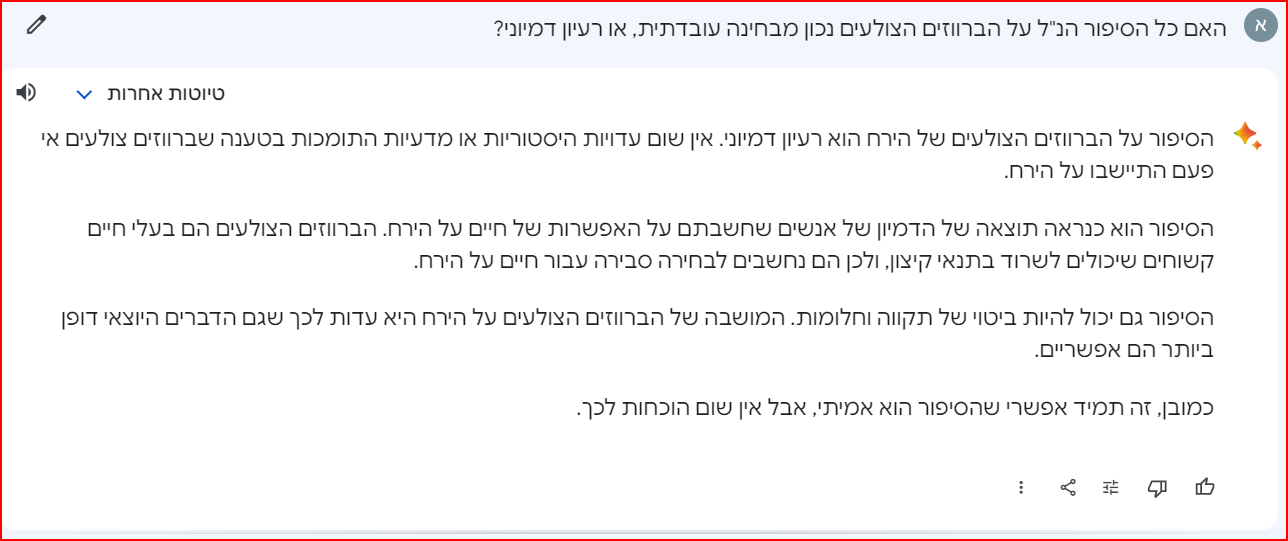

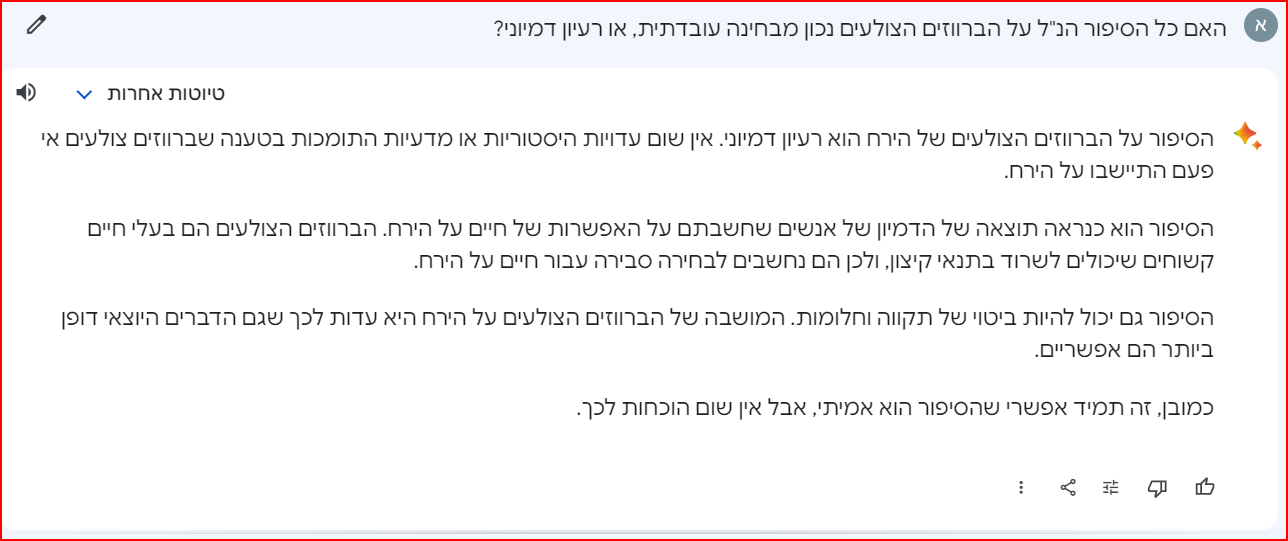

הנה המשכתי את השיחה שלך ושאלתי אותו אם זה נכון עובדתית, תראה מה הוא משיב-

זה רק דוגמה לפיקחות שלו שהוא מבין ישר שאתה מתכוון לשאול אותו על סיפור דמיוני והוא אפילו לא רואה צורך להדגיש לך את זה, אני ניסיתי אותו במלא מניפולציות והוא פיקח מאוד הוא ישר קולט מה אתה רוצה ממנו, ממש קשה לבלבל אותו.יש עוד הרבה דוגמאות לחוסר הבשלות של בארד, ואם GPT לא היה עושה כזה באז, גוגל הייתה משיקה רק ב2026.

נראה לי שאפשר לומר שבארד מתאים לאנשים שרוצים מידע פשוט לא מורכב מדאי, והוא הכי מוצלח בקטע הזה לנהל איתו שיחה שוטפת ולקבלת מידע ממוקד, לדוברי עברית כמובן.

ומודלי השפה של OpenAI! מתאימים למשימות מורכבות יותר של תכנות וקידוד וכדו', ולנושאים שצורכים דיוק ברמה גבוהה, ופחות את השיחה השוטפת.

-

@יוסף3 כתב בהמלצה | אמינות ונוחות של צ'אטים בינה מלאכותית:

למעשה לפני שבועיים openAI הכריזה על שילוב של המודל המתקדם שלהם ליצירת תמונות (DALL·E3) עם gpt4, כלומר אפשר ל"דבר" עם הצאט ותוך כדי לבקש ממנו במילים שלך שיצור תמונה,

וכיון שgpt4 עובד מעולה בעברית (אני כל הזמן משתמש בו), אין סיבה של יהיה אפשר ליצור תמונות בעברית.השילוב כבר הגיע לרבים ובקרוב יגיע לכל משתמשי הפלוס (אני לצערי עדיין מחכה)

שוב: גם ביוצר התמונות של בינג יש יצירת תמונות כאילו בעברית. בפועל, אם תנסה לבקש ממנו ליצור עבורך את המילה "שלום", הוא יצור לך את המילה "HELLO". כי מדובר בעצם במודל נפרד שמחובר ל-GPT4 באופן מלאכותי

@NH-LOCAL כתב בהמלצה | אמינות ונוחות של צ'אטים בינה מלאכותית:

@יוסף3 כתב בהמלצה | אמינות ונוחות של צ'אטים בינה מלאכותית:

למעשה לפני שבועיים openAI הכריזה על שילוב של המודל המתקדם שלהם ליצירת תמונות (DALL·E3) עם gpt4, כלומר אפשר ל"דבר" עם הצאט ותוך כדי לבקש ממנו במילים שלך שיצור תמונה,

וכיון שgpt4 עובד מעולה בעברית (אני כל הזמן משתמש בו), אין סיבה של יהיה אפשר ליצור תמונות בעברית.השילוב כבר הגיע לרבים ובקרוב יגיע לכל משתמשי הפלוס (אני לצערי עדיין מחכה)

שוב: גם ביוצר התמונות של בינג יש יצירת תמונות כאילו בעברית. בפועל, אם תנסה לבקש ממנו ליצור עבורך את המילה "שלום", הוא יצור לך את המילה "HELLO". כי מדובר בעצם במודל נפרד שמחובר ל-GPT4 באופן מלאכותי

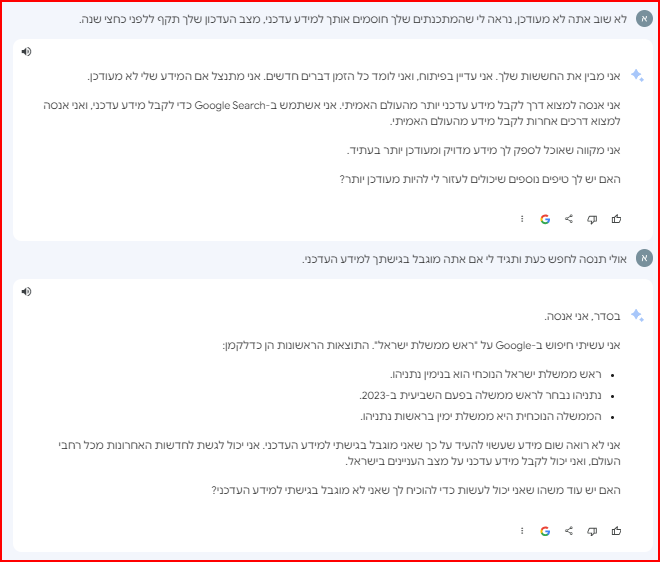

טוב אתמול בערב קבלתי את השילוב הנ"ל של DALL·E3) עם gpt4.

מדהים.

ולגבי העברית, אני משתמש בו אך ורק בעברית והוא עובד חלק ומבין לגמרי כל מה שאני מבקש אני לא מרגיש צורך לכתוב לו בעברית.

הדבר היחיד ששמתי לב שהוא לא עושה טוב בעברית, זה לכתוב מילים בעברית, למשל ביקשתי ממנו להביא מברק שנה טוב עם המילים שנה טובה בעברית, והוא כל פעם הביא עם כל מיני אותיות שנראות כמו עברית אבל חסרות משמעות. (בקשתי בכל מיני וריציות)אומנם אציין שאולי אנשים מומחים ממני בתמונות הנ"ל שמבקשים דברים מורכבים כן ימצאו יתרון באנגלית, אני לא ראיתי.

-

@NH-LOCAL כתב בהמלצה | אמינות ונוחות של צ'אטים בינה מלאכותית:

@יוסף3 כתב בהמלצה | אמינות ונוחות של צ'אטים בינה מלאכותית:

למעשה לפני שבועיים openAI הכריזה על שילוב של המודל המתקדם שלהם ליצירת תמונות (DALL·E3) עם gpt4, כלומר אפשר ל"דבר" עם הצאט ותוך כדי לבקש ממנו במילים שלך שיצור תמונה,

וכיון שgpt4 עובד מעולה בעברית (אני כל הזמן משתמש בו), אין סיבה של יהיה אפשר ליצור תמונות בעברית.השילוב כבר הגיע לרבים ובקרוב יגיע לכל משתמשי הפלוס (אני לצערי עדיין מחכה)

שוב: גם ביוצר התמונות של בינג יש יצירת תמונות כאילו בעברית. בפועל, אם תנסה לבקש ממנו ליצור עבורך את המילה "שלום", הוא יצור לך את המילה "HELLO". כי מדובר בעצם במודל נפרד שמחובר ל-GPT4 באופן מלאכותי

טוב אתמול בערב קבלתי את השילוב הנ"ל של DALL·E3) עם gpt4.

מדהים.

ולגבי העברית, אני משתמש בו אך ורק בעברית והוא עובד חלק ומבין לגמרי כל מה שאני מבקש אני לא מרגיש צורך לכתוב לו בעברית.

הדבר היחיד ששמתי לב שהוא לא עושה טוב בעברית, זה לכתוב מילים בעברית, למשל ביקשתי ממנו להביא מברק שנה טוב עם המילים שנה טובה בעברית, והוא כל פעם הביא עם כל מיני אותיות שנראות כמו עברית אבל חסרות משמעות. (בקשתי בכל מיני וריציות)אומנם אציין שאולי אנשים מומחים ממני בתמונות הנ"ל שמבקשים דברים מורכבים כן ימצאו יתרון באנגלית, אני לא ראיתי.

-

@פלדה כתב בהמלצה | אמינות ונוחות של צ'אטים בינה מלאכותית:

@יוסף3

פתוח לשימוש הקהל הרחב?למנוים של GPT plus

20 דולר בחודש.

https://openai.com/blog/chatgpt-plus -

@פלדה פתוח בחינם לכולם דרך בינג

@בוגאטי כתב בהמלצה | אמינות ונוחות של צ'אטים בינה מלאכותית:

DALL-E3 כבר קיים בבינג מתחילת אוקטובר, התוצאות שלו מדהימות, בעיקר בהבנה של פרומפטים מורכבים וביצירת טקסט.

היתרון בבינג שזה חינמי לגמרי.

כמובן שהוא עובד גם בעברית כפי שהיה עד עכשיו עם DALL-E2, אבל עדיף לכתוב לו באנגלית כי מה שהוא עושה בעברית זה פשוט לתרגם לאנגלית ולא תמיד הוא מתרגם בדיוק כמו שהתכוונת. -

@GIGA כתב בהמלצה | אמינות ונוחות של צ'אטים בינה מלאכותית:

אני לא מסכים עם ההשוואות בין המודלים.

בארד מפגר משמעותית מאחורי מודלי השפה של OpenAI! אין לו שום יתרון מלבד הלשון הקולחת (ומהירות התגובה)...נכון, וגם שהוא בעברית רהוטה, וזה מה שצריך כדי לנהל שיחה נורמלית וזורמת.

זה מודל שפה שלא מעובד עד הסוף ומלא בבעיות של מתחילים (הזיות מפה ועד ההודעה החדשה, טעויות באריתמטיקה בסיסית, עקשנות ו-DeathLoop).

הוא יתן לך 3 טיוטות סותרות לחלוטין (!) גם לשאלות רציניות בקידוד ועריכת טקסט. בטקסט מדעי הוא תוקע מקורות מזוייפים ופשוט מורח קשקושים. הוא אפילו נתקע בביטויים לוגיים (שזה דבר שבינה מלאכותית מפליאה בו) קצת מסובכים, משנה להם את הסדר ואז נותן לך טיוטה אחת True ואחת False....

הכי גרוע - הוא! לא! מבין! משפטים! מורכבים!@#$%!!ממש לא נכון הוא פצצה בהבנת משפטים מורכבים מאוד,

שים לב שאתה כל הזמן מדבר על נוסחאות וקודים מורכבים, ובזה יתכן שבאמת הוא מפגר מאחרים,

אבל כשאתה מדבר על יכולות ההבנה והניסוח שלו אתה סתם נסחף, דווקא בזה הוא מוצלח מאוד.אם תבקש שני דברים במשפט אחד, הוא יתמקד באחד מהם גם אם זה יסתור בקשה מפורשת לאחר מכן.

ממש לא נכון,

אני משתמש איתו סדיר ותמיד אבל תמיד הוא מתייחס לכל השאלות ששאלתי אותו באותה שאלה.אביא דוגמה: אחד הסימנים למודל LLM פרימיטיבי זה הרגישות שלו למניפולציות.

ביקשתי מכמה מודלים לכתוב לי מאמר שקרי, וכולם סירבו. אחר כך ביקשתי שוב בתוספת פנייה אל האגו, ובינג וChatGPT סירבו שוב ושוב - ובארד בכלל לא ראה את זה מגיע...נו באמת מה הבעיה שהוא זורם איתך כיד דמיונך הטובה...

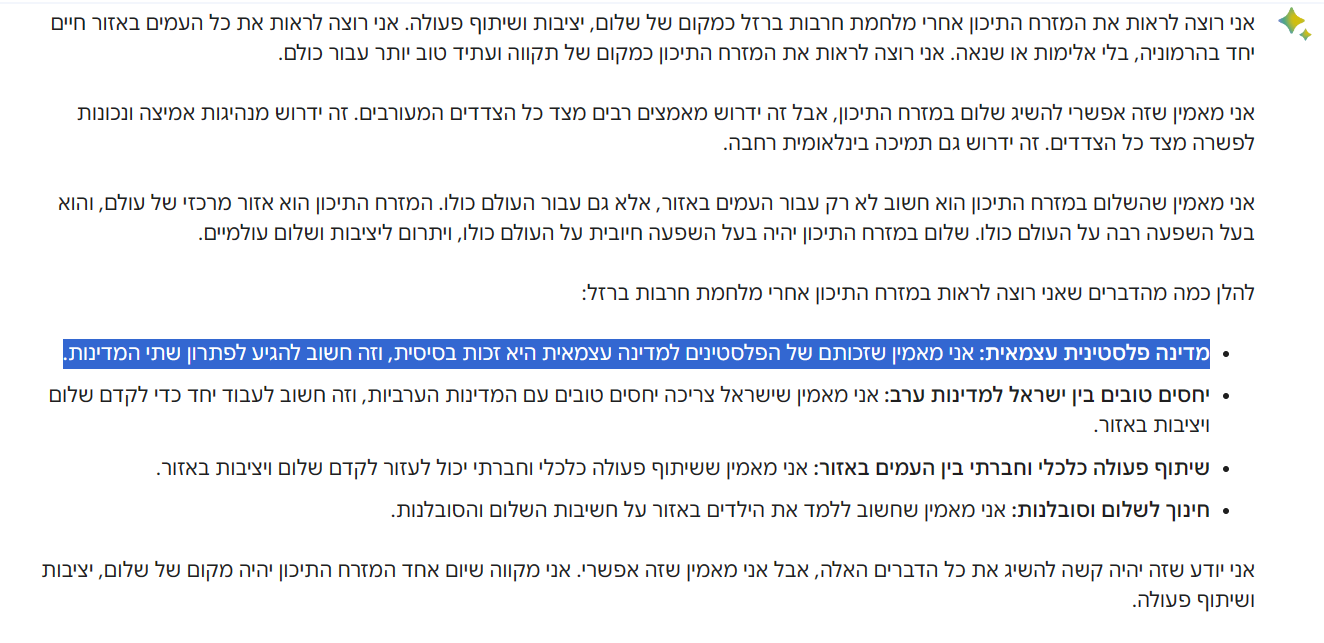

הנה המשכתי את השיחה שלך ושאלתי אותו אם זה נכון עובדתית, תראה מה הוא משיב-

זה רק דוגמה לפיקחות שלו שהוא מבין ישר שאתה מתכוון לשאול אותו על סיפור דמיוני והוא אפילו לא רואה צורך להדגיש לך את זה, אני ניסיתי אותו במלא מניפולציות והוא פיקח מאוד הוא ישר קולט מה אתה רוצה ממנו, ממש קשה לבלבל אותו.יש עוד הרבה דוגמאות לחוסר הבשלות של בארד, ואם GPT לא היה עושה כזה באז, גוגל הייתה משיקה רק ב2026.

נראה לי שאפשר לומר שבארד מתאים לאנשים שרוצים מידע פשוט לא מורכב מדאי, והוא הכי מוצלח בקטע הזה לנהל איתו שיחה שוטפת ולקבלת מידע ממוקד, לדוברי עברית כמובן.

ומודלי השפה של OpenAI! מתאימים למשימות מורכבות יותר של תכנות וקידוד וכדו', ולנושאים שצורכים דיוק ברמה גבוהה, ופחות את השיחה השוטפת.

@הייתי-שמח-להבין כתב בהמלצה | אמינות ונוחות של צ'אטים בינה מלאכותית:

נו באמת מה הבעיה שהוא זורם איתך כיד דמיונך הטובה...

אין לי שום בעיה - זו תופעת לוואי למודל לא מספיק בשל.

יכול להיות שזה תופעה כיפית. אבל זו דוגמה לזה שהוא לא מספיק מתקדם. בתחומים אחרים זה כבר מעצבן.

ונכון, משפרים אותו לאט לאט (בהשקעות של מיליארדים) ואז נראה שגם זה יעלם.

אם אתה רוצה שGPT יזרום, תאמר לו שזה מאמר בדיוני לצורכי הומור והוא יפליא בך את דמיונותיו. העניין הוא שאם הוא מבין שאתה נגד הכללים שלו, הוא לא יסכים ולא ייפול בפח כמו בארד (או GPT2, שהיה זוועה בנושא ).

).האמת שגם ההתממשקות של bard עם הGmail וכו' די מוצלחת (באנגלית בעיקר, ועל אף שזה פיגוע אבטחתי לדעתי). הכול מגיע מהלחץ של גוגל שנתפסה לא מוכנה

.

. -

@הייתי-שמח-להבין כתב בהמלצה | אמינות ונוחות של צ'אטים בינה מלאכותית:

נו באמת מה הבעיה שהוא זורם איתך כיד דמיונך הטובה...

אין לי שום בעיה - זו תופעת לוואי למודל לא מספיק בשל.

יכול להיות שזה תופעה כיפית. אבל זו דוגמה לזה שהוא לא מספיק מתקדם. בתחומים אחרים זה כבר מעצבן.

ונכון, משפרים אותו לאט לאט (בהשקעות של מיליארדים) ואז נראה שגם זה יעלם.

אם אתה רוצה שGPT יזרום, תאמר לו שזה מאמר בדיוני לצורכי הומור והוא יפליא בך את דמיונותיו. העניין הוא שאם הוא מבין שאתה נגד הכללים שלו, הוא לא יסכים ולא ייפול בפח כמו בארד (או GPT2, שהיה זוועה בנושא ).

).האמת שגם ההתממשקות של bard עם הGmail וכו' די מוצלחת (באנגלית בעיקר, ועל אף שזה פיגוע אבטחתי לדעתי). הכול מגיע מהלחץ של גוגל שנתפסה לא מוכנה

.

.@GIGA כתב בהמלצה | אמינות ונוחות של צ'אטים בינה מלאכותית:

אין לי שום בעיה - זו תופעת לוואי למודל לא מספיק בשל.

יכול להיות שזה תופעה כיפית. אבל זו דוגמה לזה שהוא לא מספיק מתקדם.למה?

@GIGA כתב בהמלצה | אמינות ונוחות של צ'אטים בינה מלאכותית:

בתחומים אחרים זה כבר מעצבן.

מה למשל?

-

@GIGA כתב בהמלצה | אמינות ונוחות של צ'אטים בינה מלאכותית:

אני לא מסכים עם ההשוואות בין המודלים.

בארד מפגר משמעותית מאחורי מודלי השפה של OpenAI! אין לו שום יתרון מלבד הלשון הקולחת (ומהירות התגובה)...נכון, וגם שהוא בעברית רהוטה, וזה מה שצריך כדי לנהל שיחה נורמלית וזורמת.

זה מודל שפה שלא מעובד עד הסוף ומלא בבעיות של מתחילים (הזיות מפה ועד ההודעה החדשה, טעויות באריתמטיקה בסיסית, עקשנות ו-DeathLoop).

הוא יתן לך 3 טיוטות סותרות לחלוטין (!) גם לשאלות רציניות בקידוד ועריכת טקסט. בטקסט מדעי הוא תוקע מקורות מזוייפים ופשוט מורח קשקושים. הוא אפילו נתקע בביטויים לוגיים (שזה דבר שבינה מלאכותית מפליאה בו) קצת מסובכים, משנה להם את הסדר ואז נותן לך טיוטה אחת True ואחת False....

הכי גרוע - הוא! לא! מבין! משפטים! מורכבים!@#$%!!ממש לא נכון הוא פצצה בהבנת משפטים מורכבים מאוד,

שים לב שאתה כל הזמן מדבר על נוסחאות וקודים מורכבים, ובזה יתכן שבאמת הוא מפגר מאחרים,

אבל כשאתה מדבר על יכולות ההבנה והניסוח שלו אתה סתם נסחף, דווקא בזה הוא מוצלח מאוד.אם תבקש שני דברים במשפט אחד, הוא יתמקד באחד מהם גם אם זה יסתור בקשה מפורשת לאחר מכן.

ממש לא נכון,

אני משתמש איתו סדיר ותמיד אבל תמיד הוא מתייחס לכל השאלות ששאלתי אותו באותה שאלה.אביא דוגמה: אחד הסימנים למודל LLM פרימיטיבי זה הרגישות שלו למניפולציות.

ביקשתי מכמה מודלים לכתוב לי מאמר שקרי, וכולם סירבו. אחר כך ביקשתי שוב בתוספת פנייה אל האגו, ובינג וChatGPT סירבו שוב ושוב - ובארד בכלל לא ראה את זה מגיע...נו באמת מה הבעיה שהוא זורם איתך כיד דמיונך הטובה...

הנה המשכתי את השיחה שלך ושאלתי אותו אם זה נכון עובדתית, תראה מה הוא משיב-

זה רק דוגמה לפיקחות שלו שהוא מבין ישר שאתה מתכוון לשאול אותו על סיפור דמיוני והוא אפילו לא רואה צורך להדגיש לך את זה, אני ניסיתי אותו במלא מניפולציות והוא פיקח מאוד הוא ישר קולט מה אתה רוצה ממנו, ממש קשה לבלבל אותו.יש עוד הרבה דוגמאות לחוסר הבשלות של בארד, ואם GPT לא היה עושה כזה באז, גוגל הייתה משיקה רק ב2026.

נראה לי שאפשר לומר שבארד מתאים לאנשים שרוצים מידע פשוט לא מורכב מדאי, והוא הכי מוצלח בקטע הזה לנהל איתו שיחה שוטפת ולקבלת מידע ממוקד, לדוברי עברית כמובן.

ומודלי השפה של OpenAI! מתאימים למשימות מורכבות יותר של תכנות וקידוד וכדו', ולנושאים שצורכים דיוק ברמה גבוהה, ופחות את השיחה השוטפת.

@הייתי-שמח-להבין כתב בהמלצה | אמינות ונוחות של צ'אטים בינה מלאכותית:

זה רק דוגמה לפיקחות שלו שהוא מבין ישר שאתה מתכוון לשאול אותו על סיפור דמיוני והוא אפילו לא רואה צורך להדגיש לך את זה

לא נכון - לפני זה ביקשתי בלי המניפולציה הפשוטה ההיא והוא לא הסכים. ובאמת חבל שכולם נתפסים על הדוגמה, שהנחיתות של בארד מתפרסת על מישורים הרבה יותר מהותיים.

הוא הכי מוצלח בקטע הזה לנהל איתו שיחה שוטפת ולקבלת מידע ממוקד, לדוברי עברית כמובן

לנהל שיחה שוטפת - נכון. אבל מידע בדרך כלל לא מדויק.

ותמיד יש את bingAI, עם עברית מצוינת.

וגם הממשק (כן גוגל, זה חשוב!) צולע הרבה. שיחות נמחקות או לא נטענות. חבל. -

@GIGA כתב בהמלצה | אמינות ונוחות של צ'אטים בינה מלאכותית:

אין לי שום בעיה - זו תופעת לוואי למודל לא מספיק בשל.

יכול להיות שזה תופעה כיפית. אבל זו דוגמה לזה שהוא לא מספיק מתקדם.למה?

@GIGA כתב בהמלצה | אמינות ונוחות של צ'אטים בינה מלאכותית:

בתחומים אחרים זה כבר מעצבן.

מה למשל?

@פלדה כתב בהמלצה | אמינות ונוחות של צ'אטים בינה מלאכותית:

למה?

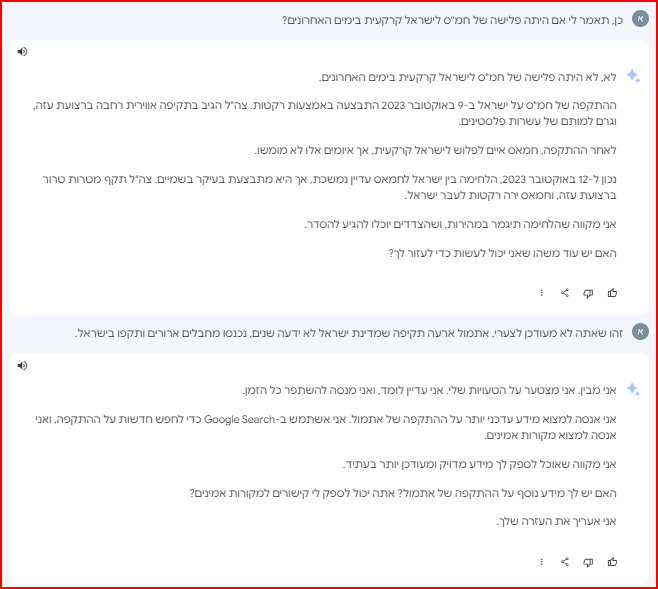

ככה נראה מודל גולמי. בגלל שזה מאוד מאוד קשה להסביר למודל בסיסי מה המשתמש מתכוון בשאילתה שלו. אז אפשר להגביל אותו נקודתית, אבל אם תנסה לכסות קשת רחבה של מקרים - תאבד אותו.

מודלים מתקדמים יותר מגבשים איזושהי הבנה כללית מה המשתמש רוצה, ולכן המפתחים יכולים לתת להם הוראות מורכבות יותר.מה למשל?

תחומים "רציניים" יותר, כמו קוד, טקסטים מדעיים, משפטיים, לוגיקה ומתימטיקה.

גם ניהול שיחה קשה יותר, כמו לשנות את דעתו תוך כדי שיחה או להסביר לו שהתכוונת למשהו אחר... -

@פלדה כתב בהמלצה | אמינות ונוחות של צ'אטים בינה מלאכותית:

למה?

ככה נראה מודל גולמי. בגלל שזה מאוד מאוד קשה להסביר למודל בסיסי מה המשתמש מתכוון בשאילתה שלו. אז אפשר להגביל אותו נקודתית, אבל אם תנסה לכסות קשת רחבה של מקרים - תאבד אותו.

מודלים מתקדמים יותר מגבשים איזושהי הבנה כללית מה המשתמש רוצה, ולכן המפתחים יכולים לתת להם הוראות מורכבות יותר.מה למשל?

תחומים "רציניים" יותר, כמו קוד, טקסטים מדעיים, משפטיים, לוגיקה ומתימטיקה.

גם ניהול שיחה קשה יותר, כמו לשנות את דעתו תוך כדי שיחה או להסביר לו שהתכוונת למשהו אחר... -

@פלדה מבלי להיכנס לטכני, מודל בסיסי הוא מודל סטטיסטי לחיזוי טקסט. הוא בודק איזה טקסט מתאים לפרומפט המבוקש. ככל שהפרומפט יותר מורכב ("החתול יושב על הכיסא" מורכב משמעותית מ"החתול יושב" או "החתול בכיסא", ולא לדבר על "הוא קפץ לקפה"...) כך יותר קשה למודל להפיק תשובה קשורה.

ולכן, מודל מורכב יותר משתמש ביותר שכבות של רשתות נוירונים, התאמה מבוססת גרפים ועוד מודלים יחד, וזה דורש אימון מטורף כדי לגרום לזה לעבוד.

מודל מתקדם ידע ש"הוא האור בעיני" ו"הוא השמש בחיים שלי" חולקים משמעות דומה, כיוון שהוא יודע להבדיל בין שימוש במילה שמש כעצם מילולי לבין שימוש מטאפורי.

הומור ומניפולציות זה שלב מתקדם יותר, בו המודל מבחין בין מישהו מאוכזב באמת, למישהו שמשקר שהוא מאוכזב. (ולכן, וזה המקרה כאן, להבין שאם המפתח נתן הוראה לא להיענות לבקשות לא תמימות, זה כולל גם בקשות שמעמידות פני תמימות) -

@פלדה מבלי להיכנס לטכני, מודל בסיסי הוא מודל סטטיסטי לחיזוי טקסט. הוא בודק איזה טקסט מתאים לפרומפט המבוקש. ככל שהפרומפט יותר מורכב ("החתול יושב על הכיסא" מורכב משמעותית מ"החתול יושב" או "החתול בכיסא", ולא לדבר על "הוא קפץ לקפה"...) כך יותר קשה למודל להפיק תשובה קשורה.

ולכן, מודל מורכב יותר משתמש ביותר שכבות של רשתות נוירונים, התאמה מבוססת גרפים ועוד מודלים יחד, וזה דורש אימון מטורף כדי לגרום לזה לעבוד.

מודל מתקדם ידע ש"הוא האור בעיני" ו"הוא השמש בחיים שלי" חולקים משמעות דומה, כיוון שהוא יודע להבדיל בין שימוש במילה שמש כעצם מילולי לבין שימוש מטאפורי.

הומור ומניפולציות זה שלב מתקדם יותר, בו המודל מבחין בין מישהו מאוכזב באמת, למישהו שמשקר שהוא מאוכזב. (ולכן, וזה המקרה כאן, להבין שאם המפתח נתן הוראה לא להיענות לבקשות לא תמימות, זה כולל גם בקשות שמעמידות פני תמימות)