ברור | בינה מלאכותית להרצה מקומית

-

ל למעיישה סימן נושא זה כשאלה

-

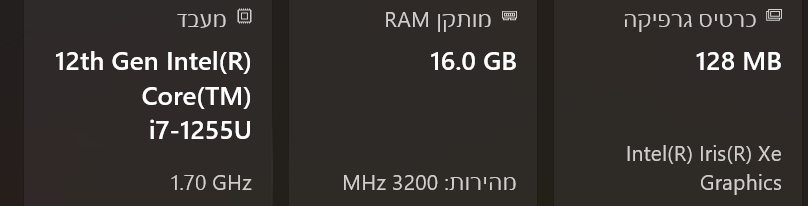

ללא כרטיס מסך וכמות קטנה יחסית של RAM אני לא יודע אם זה שווה את המאמץ כי התוצאה בסוף תהיה מודל איטי מאוד ששוכח מה אמרת מאוד מהר ולא כול כך יעיל

בכול מקרה לשאלתך אני ממליץ מודל עם מקסימום 7 מיליארד פרמטרים

אין הרבה כאלה

אז בקיצור תשתמש ב- Llama 2 7b

2.mistral (הגרסה הקטנה)

התוצאה שתקבל לדעתי לא שווה את המאמץ אבל בכול מקרה מה שאתה מחפש נקרא מודלים שהם CPU-only

בהצלחה - Llama 2 7b